Wie viel sind 16 GB für AI?

|

13.11.2024

Mit 16 GB sind die Macs fit für AI, sagt Apple. Das klingt so, als handele es sich um eine feste Größe: AI benötigt so-und-so-viel Speicher, und alle Macs verfügen ab sofort über eben diese Menge. Das stimmt jedoch nur in sehr engen Grenzen.

Wie immer hängt alles von der jeweiligen Anwendung ab. 16 GB Speicher sind knapp ausreichend für jene Funktionen, die in macOS derzeit eingebaut werden. Dabei handelt es sich größtenteils um Textfunktionen. Charakteristisch ist, dass dabei keine intelligenten Schlüsse gezogen werden müssen (»Reasoning«), sondern die KI verwendet einfache statistische Modelle, um bestimmte Textmerkmale zu erkennen, beispielsweise den Tonfall eines Textes (ernst, lustig, knapp, redselig) oder die wesentlichen inhaltlichen Schwerpunkte.

Letzteres ist möglich, indem man untersucht, ob bestimmte Worte zueinander in Beziehung stehen (Beispiel: Fisch, Aquarium, Wasser). Falls sich solche Beziehungen in separate Gruppen auftrennen lassen, sind es unterschiedliche Schwerpunkte. Weitere Hinweise gibt der Text durch Worte wie »Andererseits« oder »Zweitens«. Auch hier handelt es sich um einfache statistische Funktionen.

Es ist verblüffend, wie viele Anwendungen davon profitieren. In Final Cut beispielsweise kann Sprache erkannt und in Untertitel verwandelt werden — eine ansonsten sehr mühsame Arbeit. Telefonate können transkribiert und in eine kurze Zusammenfassung überführt werden. Es sind also nicht nur Textprogramme, die dadurch besser werden.

Die zusätzlichen 8 GB sind daher gut investiert in Grundfunktionen, die sehr vielen Anwendern helfen werden, und die uns bald selbstverständlich vorkommen dürften. Apple macht hier alles richtig.

Aber es sind eben Grundfunktionen, nicht mehr. Sie funktionieren nur innerhalb eines engen Rahmens, den Apple vorgibt. Der eigentliche Zauber der KI ist jedoch, dass man sie frei verwenden kann — anders als klassische Software, bei der jede Funktion zuvor programmiert werden muss. Diese Freiheit bietet Apple nicht, denn es ist mit 8 GB gar nicht möglich.

Deswegen hat Apple vorgesehen, umfangreiche Berechnungen auf Apples Servern auszuführen. Welche Fähigkeiten diese KI hat, ist unbekannt. Sie muss wohl deutlich weniger leistungsfähig sein als ChatGPT, sonst würde Apple keine Integration von ChatGPT anbieten.

Zurück zur Speichergröße. Wie viel RAM müsste man aufwenden, um eine kleine, spezialisierte KI lokal auf dem Mac laufen zu lassen, die zumindest in ihrem spezialisierten Themengebiet so gut wäre wie die besten derzeitigen KI-Modelle? Beispielsweise, wenn man eine KI bräuchte, die einem beim Programmieren oder beim Komponieren oder bei Mathe-Aufgaben helfen soll, und die das so gut bewerkstelligen könnte wie ChatGPT 4.o?

Es wären ungefähr 32 GB. Die reinen Daten des KI-Modells betrügen um die 20 GB, und dann bräuchte die Engine noch etwas Luft zum Atmen. Zusätzlich benötigt der Mac noch RAM für macOS und irgendwelche Apps. Am Ende würde man bei 64 GB RAM landen, oder vielleicht bei 48 GB.

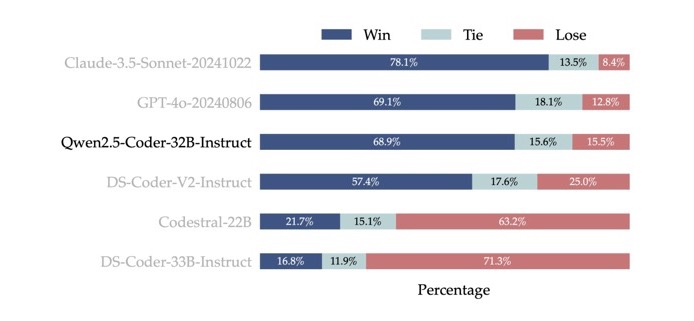

(Die Grafik oben zeigt, dass das schlanke Modell mit 32 Milliarden Parametern (20 GByte) in etwa so gut programmieren kann wie ChatGPT 4.o)

Dabei muss man wissen, dass solche schlanken Modelle noch sehr neu sind. Unter den Entwicklern gibt es derzeit viel Jubel und Staunen, dass man sowas überhaupt mit 32 GB RAM realisieren kann. Es ist nicht die Regel, sondern eine aufregende neue Errungenschaft. Je nach Themengebiet kann es auch mehr RAM benötigen oder weniger gut funktionieren. Wir sollten diese Zahlen also als unterste Grenze verstehen.

Wer wirklich ernsthafte und größere Aufgaben mit KI erledigen möchte, der wird wohl eher zu einem Mac mit 128 GB RAM greifen. Aber dann stellt sich die Frage, welcher mörderische Prozessor mit derart vielen Daten umgehen kann. Es kommt auf möglichst viele GPU-Kerne an. Wer also so viel Geld ausgibt für RAM, der wird wohl auch die Max- oder Ultra-Version des M-Prozessors wählen.

Oder er pfeift drauf und verwendet einfach die Server-Dienste von ChatGPT, Google Gemini oder Anthropic Claude. Die allermeisten Anwender werden sich dafür entscheiden, und deswegen ist Apples Idee mit kleinen lokalen KI-Modellen und verschiedenen, wählbaren Cloud-Diensten genau richtig. Jedenfalls in diesem Jahr.

Was bedeutet das alles? Zunächst ist es eine Binsenweisheit, dass die minimale Ausstattung der Macs eben nichts weiter ist als das: die minimale Ausstattung. Wer viel vorhat, muss seinen Mac auch entsprechend aufrüsten. Neu ist die Erkenntnis, dass lokale KI-Modelle ganz außerordentlich viel RAM und Rechenleistung benötigen. 64 GB waren bis vor kurzem noch das Maximum bei den M-Prozessoren. Da macOS sehr effizient ist, sind 64 GB wirklich viel. Aber in der kommenden KI-Epoche wird es wenig sein.

Diskussion im Forum

Aktuelle Sendung dazu: AI rückt näher: Wo stehen wir und wie geht es weiter?

|