WWDC 2024: Wie klug wird Apples KI sein, und was wird sie kosten?

|

11.04.2024

Man könnte annehmen, dass es unmöglich wäre, beide Fragen zu beantworten, bis Apple zur WWDC 2024 endlich den Vorhang beiseite zieht. Woher will man wissen, was eine unbekannte Software leisten wird?

Natürlich ist das spekulativ. Aber man kann Spielräume ausloten, die sich Apple demnächst bieten. Der Zweck des Artikels ist also nicht, definitive Behauptungen aufzustellen, sondern darzulegen, wie das Umfeld aussieht, in dem sich Apple bewegt.

Es bewegt sich

Zunächst: Bewegt sich Apple überhaupt? Die kurze Antwort ist: Ja, das wissen wir sicher. Die massiv skalierte KI, und dort ein ganz spezielles Phänomen namens MMLU, wird die gesamte Software-Industrie auf den Kopf stellen.

MMLU bedeutet: Massive Multitask Language Understanding. Damit ist die Fähigkeit gemeint, verschiedene Wissensbereiche (»Multitask«) so zu verstehen, dass es einem Expertenwissen entspricht. Gemessen wird es an komplexen Benchmarks, aber man kann es sich vereinfacht so vorstellen, dass man die KI mit den Fragen einer Examensprüfung in Jura, Medizin, Informatik oder anderen Wissensbereichen konfrontiert, und dann misst, wie viele Aufgaben korrekt gelöst wurden. Das Ergebnis wird dann in Prozent ausgedrückt, beispielsweise 87%.

Entscheidend ist dabei eine Sache, die in der Öffentlichkeit oft missverstanden wird: Es geht hier nicht um reines Wissen, also nicht um ein Nachplappern von Wikipedia-Artikeln. Sondern es geht bei MMLU darum, Schlüsse zu ziehen. Es geht um das Verständnis eines Sachverhalts oder eines Problems. Anschließend muss die KI ihr Wissen darauf anwenden, um zu einer Lösung zu gelangen. In der Öffentlichkeit werden die KI-Systeme oft gebraucht als ein bequemer Ersatz für Google, quasi als Suchmaschine für »die richtige Antwort«. Aber das ist nicht, was die neue KI so interessant macht.

Ein Beispiel: In der letzten Live-Sendung vom 7. April habe ich demonstriert, wie eine KI aus einem Artikel von MacRumors.com jene Abschnitte erkennt, die zu einer Kontroverse führen könnten. Das Ziel war, ein Sendekonzept für Mac-TV zu schreiben. Dazu muss man erkennen, worin die diskussionswürdigen Details bestehen. Die KI hat nicht nur die Kontroversen gefunden, sondern auch, welche Pro- und Contra-Argumente man dabei abwägen müsste.

Das beweist, das MMLU tatsächlich ein Verständnis für das jeweilige Thema entwickeln kann. Bei dem Demo handelte es sich nur um einen »Shortcut«, also um keine ausgefeilte Software. Aber man kann sich ausmalen, was größere Teams mit besseren Werkzeugen damit anstellen können (und werden).

Skalierung

Diese verblüffende Fähigkeit ergibt sich aus einer massiven Skalierung. Die KI-Modelle sind mittlerweile so gigantisch groß, dass man es sich kaum vorstellen kann. Das Demo mit dem Sendekonzept basiert auf GPT-4, was angeblich 1,8 Billionen (1800 Milliarden) Parameter so verschaltet und gewichtet, dass am Ende diese Fähigkeiten entstehen. Derzeit skizziert man schon Modelle, die auf 10 Billionen Parameter basieren — niemand weiß genau, welche Fähigkeiten dadurch möglich werden.

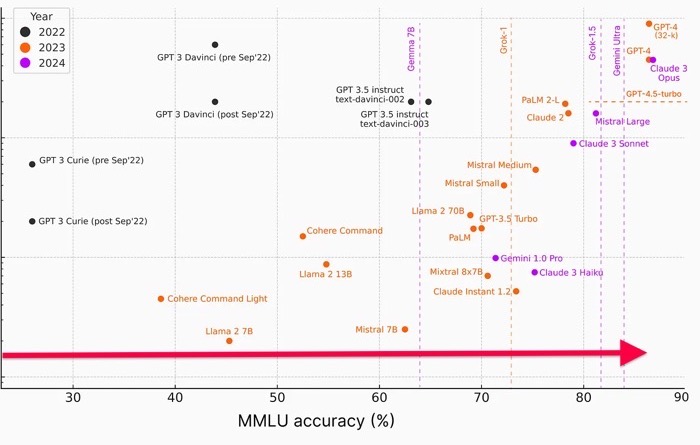

Man weiß aber sicher, dass die Fähigkeit, Schlüsse zu ziehen, mit der Größe der Modelle wächst. Hier ist eine Grafik, die das anschaulich macht:

Die Grafik zeigt die Namen verschiedener KI-Modelle. Der rote Pfeil weist die Richtung, in der man die Grafik lesen muss. Je weiter rechts sich eine KI befindet, desto besser schneidet sie bei den MMLU-Tests ab. Die besten Systeme liegen bei 85 Prozent. Das kostenlose ChatGPT 3.5, was derzeit die meisten Anwender benutzen dürften, liegt bei nur 65 Prozent.

In einer einzigen Generation gelang GPT ein Sprung von 65 auf 85 Prozent. Googles »Gemini« sprang von 70 auf 85 Prozent. Das sind Werte von Systemen, die 2023 entstanden. Was wird wohl im Jahr 2024 entstehen?

Je mehr Parameter die Modelle haben, desto schlauer werden sie offenbar. Ganze Rechenzentren müssen monatelang vor sich hin rechnen, um derart leistungsfähige KI-Gehirne zu erzeugen. Anschließend folgen noch weitere Stufen zum Training, die ungefähr ein halbes bis ganzes Jahr dauern. Eine neue Generation benötigt derzeit etwa ein Jahr an Rechenzeit und Training.

Merke: Die Leistung ist verbunden mit Skalierung; und die Skalierung ist verbunden mit Kosten.

Der Preis ist heiß

Es sind massive Investitionen, die vorab getätigt werden müssen, ehe man auch nur einen Cent verdienen könnte. Microsoft hat gerade beschlossen, ein Budget von 100 Milliarden Dollar bereitzustellen, um damit neue Rechenzentren zu bauen. Das sind selbst im Zeitalter von Cloud-Diensten völlig unbekannte Dimensionen. Auch für Apple sind das astronomische Zahlen.

Wir sind es gewohnt, dass fast alles, was mit dem Internet zu tun hat, kostenlos verteilt wird. Aber solche Beträge kann niemand einfach verschenken.

Oder vielleicht doch? Oder beinahe? Es gibt nämlich durchaus einen Markt für einfache und billige Systeme. Manche Aufgaben erfordern nicht viel Rechenzeit oder können sogar lokal auf dem Gerät berechnet werden. Für einfache Zwecke kann das reichen. Andererseits ist es für Apple immer verlockend, einen Premium-Preis für das beste Produkt zu verlangen. Und hier scheint die neue KI eine wahre Goldgrube zu sein. Denn die besten KI-System sind nicht etwa ein paar Prozent teurer. Sie kosten auch nicht das Doppelte. Sondern das Zehnfache.

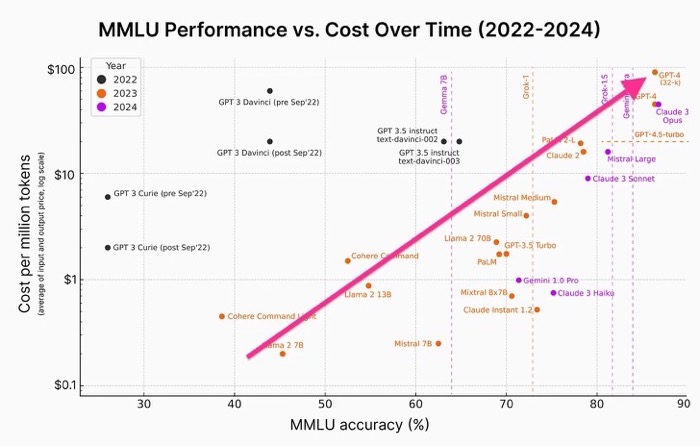

Das Bild oben zeigt die Preise für KI-Systeme auf einer logarithmischen Skala, d.h. jeder Skalenstrich (von oben nach unten) bedeutet eine Verzehnfachung. Man kann daran ablesen, dass die besten Systeme mit 100 Dollar pro 1 Million »Tokens« abgerechnet werden. Es existiert ein mittleres Segment, zu dem auch ChatGPT 3.5 zählt. Es kostet 10 Dollar. Dann gibt es eine Reste-Rampe für 1 Dollar.

Das bedeutet: Die besten Anbieter können einen zehnfachen oder sogar hundertfachen Preis verlangen. Klingt das nach Apple?

Falls Apple tatsächlich zu den Besten gehören wird (irgendwann in der Zukunft), dann muss Apple gigantische Investitionen wettmachen. Die Gerüchte, Apple würde iOS 18 einfach so mit wunderlichen KI-Fähigkeiten ausstatten, sind sehr wahrscheinlich falsch. Richtig ist vermutlich, dass Apple recht niederwertige KI-Fähigkeiten einbauen wird, die in einem begrenzten Rahmen nützlich sein werden, beispielsweise begrenzt auf bestimmte Funktionen innerhalb einer App.

Bestimmte hochwertige Funktionen gibt es eben nur mit iCloud+ oder »iCloud AI«, weil hochwertige KI eine unglaubliche Rechenleistung erfordert, wie sie nur Rechenzentren bieten. Abgerechnet wird es per 100 Anfragen zu je 5 Dollar. Oder so ähnlich.

Apple hat im Prinzip zwei Möglichkeiten, um mit den Kunden ins Geschäft zu kommen. Entweder bieten sie das beste Produkt. Oder das bequemste: Wenn die Funktionen hübsch integriert sind in die Apps, die wir sowieso benutzen, und wenn wir dazu nur einen Schalter bewegen müssen, um mehr Leistung zu erhalten — dann werden viele Kunden bei Apple bleiben. Das ist das Prinzip von iCloud.

Auf der anderen Seite: Die besten und teuersten KI-Systeme sind derzeit zu Leistungen imstande, die absolut haarsträubend sind. Wer das gesehen hat und für sich nutzen kann, wird es haben wollen, egal von wem. In den letzten zwei Jahrzehnten waren wir es gewohnt, dass PC-Anwender zum Mac gewechselt sind. Der Trend könnte sich wieder umkehren. Der Unterschied zwischen den »mäßigen« und den »guten« KI-Systemen ist größer als das, was Apple mit der Eleganz ihrer Software wettmachen könnte. Manchmal zählt einfach die schiere Leistung.

Niemand weiß das besser als Apple. Warum? Weil Apple Tausende von Programmierern beschäftigt, die diese Revolution als erste spüren. KI-Systeme können einen Programmierer produktiver machen auf eine Weise, die einfach unglaublich ist. Ich sage voraus, dass es innerhalb eines Jahres keinen Programmierer mehr geben wird, der ohne einen KI-Assistenten arbeitet. Die ganze Branche wird innerhalb eines Jahres komplett umgekrempelt. In Apples Großraumbüros wird vermutlich über kaum etwas anderes geredet. Es ist absolut unmöglich, dass Tim Cook es überhört.

Was sagt uns das?

Apples zukünftige KI wird vermutlich sehr klug sein und irgendwann 90 Prozent eines MMLU-Benchmarks erreichen — weil es die besten Systeme heute schon können. Diese Klugheit wird einen Preis haben und nicht kostenlos in iOS oder macOS integriert sein. Die kostenlose Variante wird nur die Grundschule besucht haben. Aber für begrenzte Szenarien innerhalb von Apps wird sie nützlich sein.

Wir können eine weitere Vorhersage wagen: Das ganze Unterfangen ist riesig groß. Man muss sich ganz und gar darauf einlassen, oder man lässt es besser bleiben. Man kann nicht Milliarden ausgeben für eine unwichtige Funktion in irgendeiner App. Aber das ist der Preis, um überhaupt noch mitspielen zu können. Apple hat keine Wahl, als mit beiden Füßen auf den neuen Zug aufzuspringen. Entsprechend vielfältig werden Apples Versuche sein, seine Investitionen wieder reinzuholen.

Diskussion im Forum

|